Es importante señalar que al desarrollar sistemas altamente cargados sólo se utiliza una CPU para evitar altas latencias de acceso a la memoria debido a la arquitectura NUMA.

El BRAS/BNG tiene una serie de características en comparación con las soluciones de software y hardware:

- Independencia del fabricante de hardware

- Posibilidad de utilizar los equipos existentes

- Despliegue rápido

- Posibilidad de crear stands de demostración en la Virtual Machine para verificar la configuración

- Escalabilidad flexible al aumentar el rendimiento.

VAS Experts tiene una amplia experiencia en la implementación de soluciones de expansión BRAS. A menudo, nuestros clientes enfrentan el desafío de la escala en los equipos de red, y esto es lo que dicen sobre su experiencia de desarrollo y migración:

«La migración de Stingray SG-20 a Stingray SG-40 fue absolutamente fácil. El software Stingray funcionó sin errores y la migración se realizó sin problemas».

Roman Trepalin, Post Ltd.

En este artículo, hablaremos sobre varias opciones de expansión en detalle con ejemplos de escalado.

Scale-up (Vertical)

La extensión vertical es la extensión dentro de un mismo dispositivo para alcanzar el rendimiento deseado. El límite de rendimiento actual por servidor es de hasta 100G full duplex. En el futuro, el límite se aumentará al lanzar nuevos procesadores. Se recomienda el uso de un servidor de reserva al cual se puede transferir la carga en caso de fallo del servidor principal.

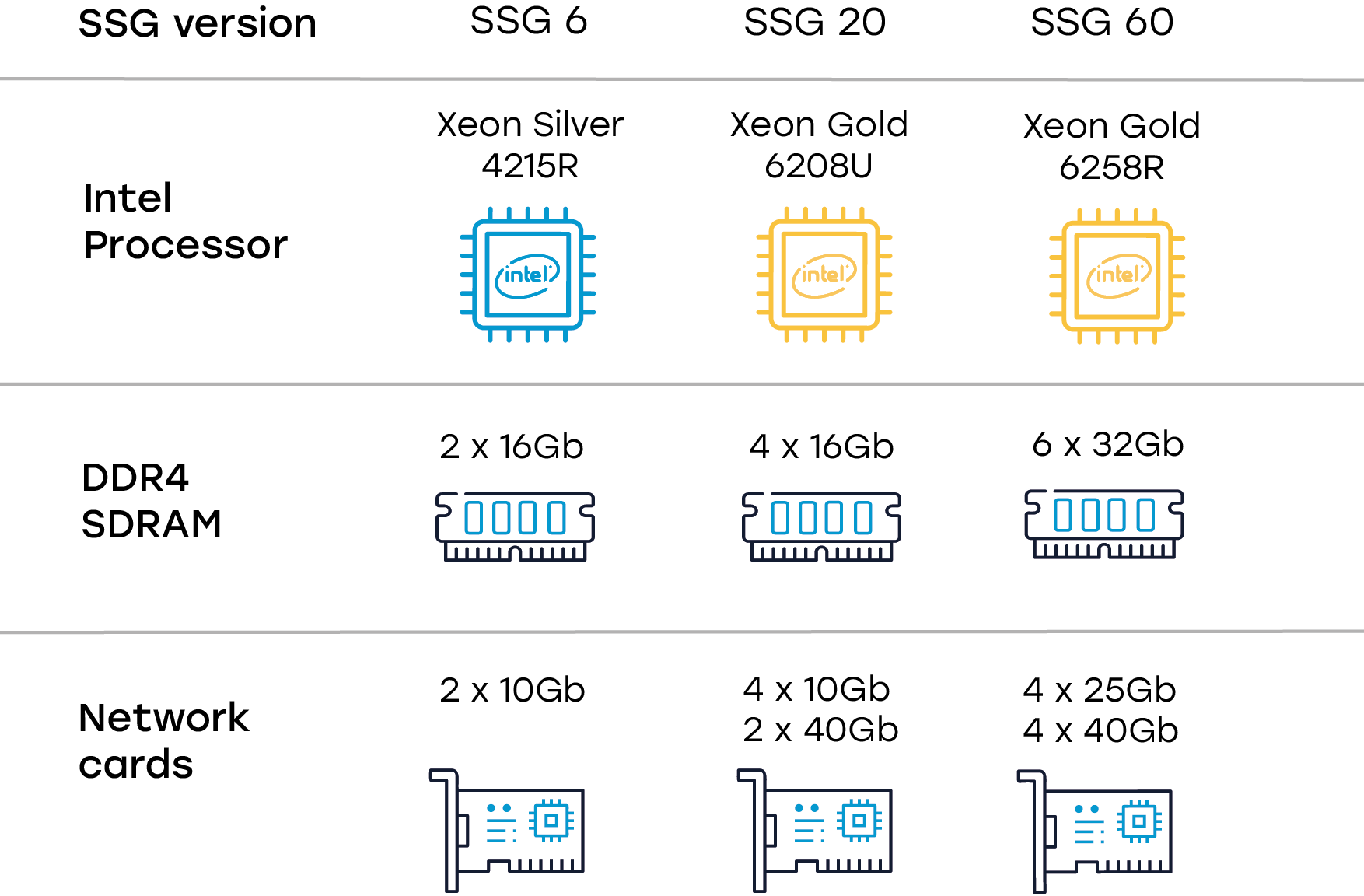

Ejemplo de escalado con servidores Intel

La memoria es escalable en función de las necesidades: al principio se puede utilizar una plataforma con 8 núcleos, y luego es posible ampliarla a plataformas de 16 y 28 núcleos. Las tarjetas de red se pueden utilizar con puertos de 10G/25G/40G, en ese caso la combinación de diferentes tipos de puertos no es compatible.

He aquí un ejemplo de extensión del Stingray-6 al Stingray-60 en la misma plataforma.

Plataforma: Supermicro SYS-5019P-WTR

Características clave:

- Single Socket P (LGA 3647) compatible con el procesador escalable Intel® Xeon® de segunda generación (Cascade Lake/Skylake)

- 6xDIMMs; hasta 1,5TB 3DS ECC DDR4-2933MHz RDIMM/LRDIMM

- 2 slots PCI-E 3.0 x16 (FHFL), 1 slot PCI-E 3.0 x8 (LP)

- 4 bahías de disco SATA3 de 3,5″ de intercambio rápido

- 2 puertos 10GBase-T con Intel X722 + X557

- 1xVGA, 2 COM, 2 USB 3.0, 2 USB 2.0

- 2 puertos SuperDOM (Disco en el módulo)

- Fuentes de alimentación redundantes de 500 W con certificación Platinum Level

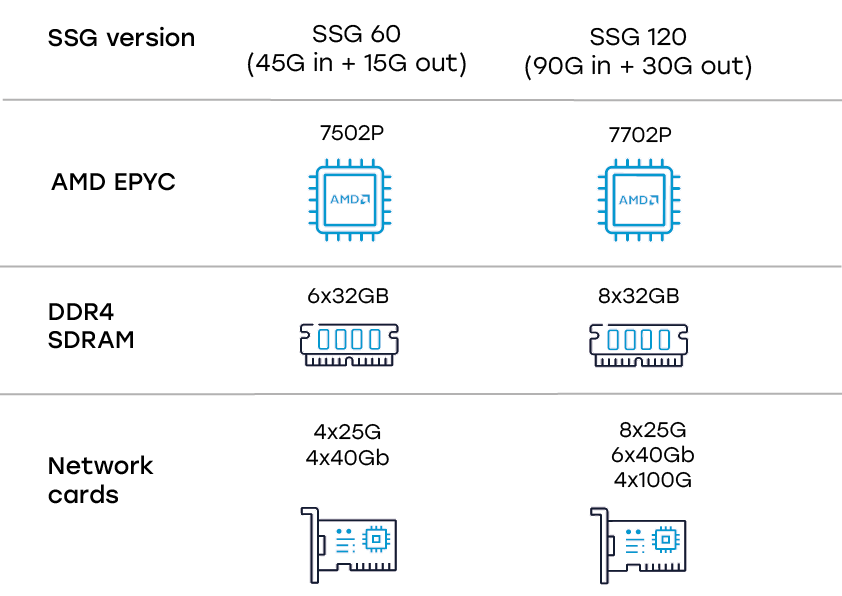

Ejemplo de escalado con servidores AMD

Los procesadores multinúcleo de AMD se adaptan perfectamente a los sistemas en los que se requiere un rendimiento desde 50G full dúplex. El rendimiento también se incrementa sustituyendo el procesador y añadiendo memoria y adaptadores de red.

He aquí un ejemplo de extensión del Stingray-60 al Stingray-120 en la misma plataforma.

Plataforma: Supermicro AS-1014S-WTRT o Supermicro AS-2113S-WTRT.

Importante, para utilizar las interfaces de 100G, se debe instalar una placa base compatible con PCI 4.0.

Características clave:

- Procesador Single AMD EPYC™ serie 7002

- 8xDIMMs; hasta 2TB 3DS ECC DDR4-3200MHz RDIMM/LRDIMM

- 2 slots PCI-E 4.0 x16 (FHFL), 1slot PCI-E 4.0 x16 (LP)

- IPMI 2.0 integrado + KVM con LAN dedicada

- 4 Bahías de disco SATA3 de 3,5″ con intercambio en caliente, compatibilidad opcional con 4 unidades U.2 NVMe (PCI-E 3.0) mediante un kit adicional para dispositivos NVMe

- 2 puertos LAN 10GBase-T a través del controlador Broadcom BCM57416

- 1xVGA, 5xUSB 3.0 (4 traseros, 1 Tipo A)

- 2 puertos SuperDOM (Disco en el módulo)

- Fuentes de alimentación redundantes de 500W con Platinum Level de alta eficiencia

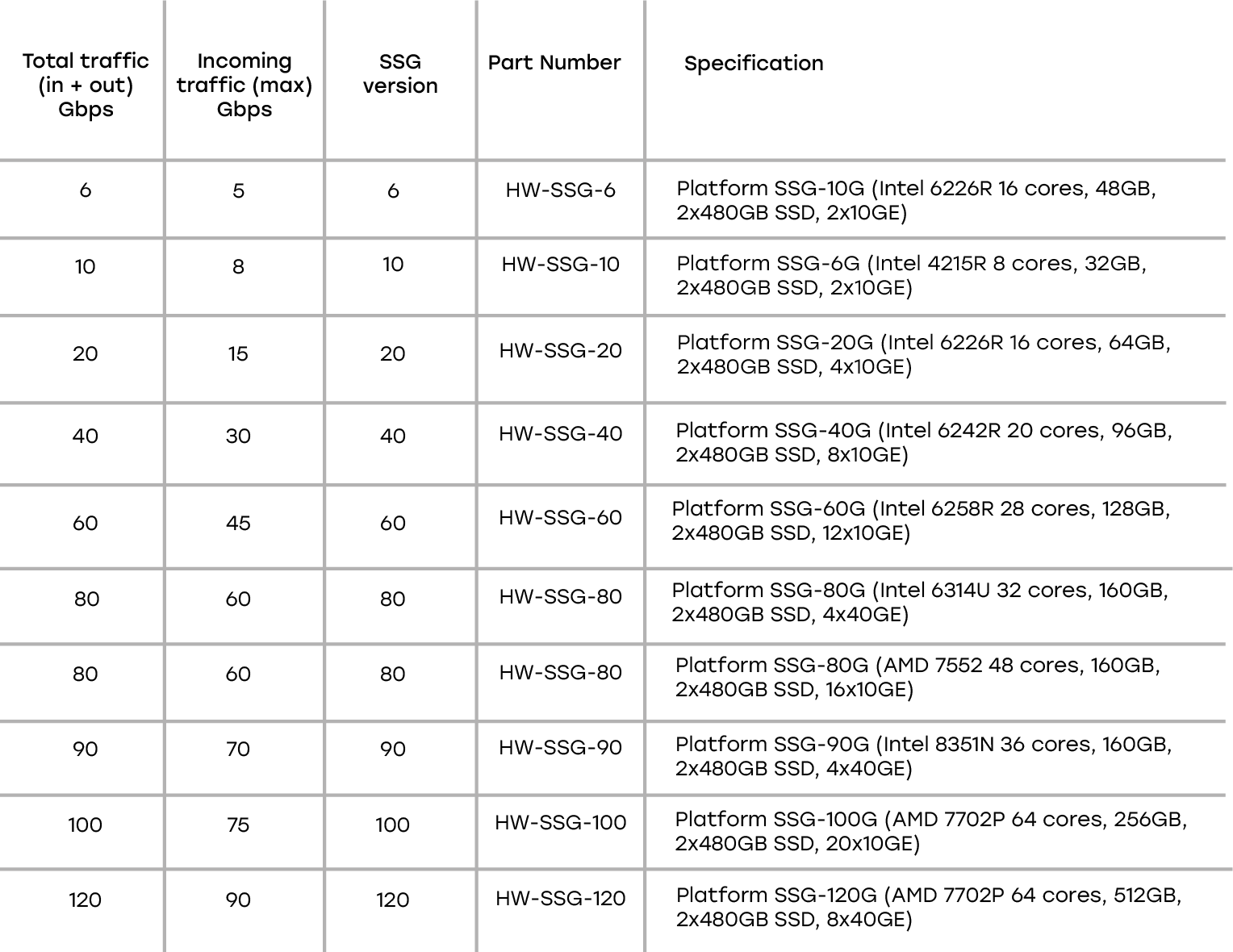

Ejemplo de especificaciones de plataforma en Supermicro

Al utilizar el Stingray Service Gateway como L2 BRAS/BNG (autorización DHCP/ARP/PPPoE), es necesario tener en cuenta la carga adicional para analizar cada paquete en busca de parámetros adicionales. Esto da lugar a un mayor consumo de energía de la CPU. En estos escenarios, se recomienda aumentar el número de núcleos de la CPU en un 30%. Para la licencia SSG-40, utilice la plataforma SSG-60.

Scale-out (Horizontal)

La extensión horizontal se realiza utilizando varios servidores Stingray Service Gateway para dividir y equilibrar la carga. Al aumentar el número de servidores, se resuelve la situación cuando no es posible procesar todo el tráfico en un solo dispositivo. En este caso, la tolerancia a fallos de la solución en general aumenta.

Se recomienda considerar el rendimiento de cada dispositivo en una situación en la que se pretende transferir el tráfico del servidor retirado a otro.

Veamos las opciones de escalado y redundancia por separado para los esquemas L2 y L3 BRAS.

Condiciones:

- BRAS/BNG idéntico en términos de rendimiento y licencias

- El servidor PCRF sincroniza las bases internas de UDR (estado de la autorización, supervisión, servicios).

L3-Connected BRAS

El L3 IPoE BRAS/BNG interactúa con los suscriptores a través de los enrutadores intermedios, por lo que no ve las direcciones MAC originales, mientras que los suscriptores ya tienen asignadas las direcciones IP. La asignación de direcciones IP en este esquema se realiza de forma estática en las configuraciones de red o en los conmutadores de acceso a través del DHCP Relay.

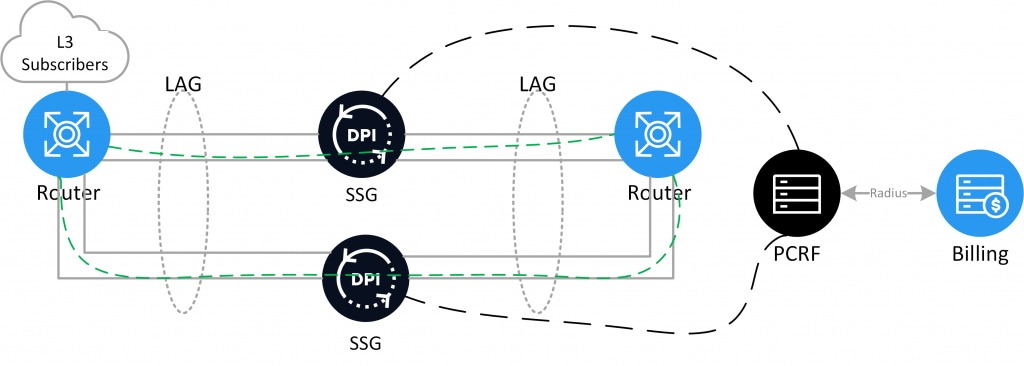

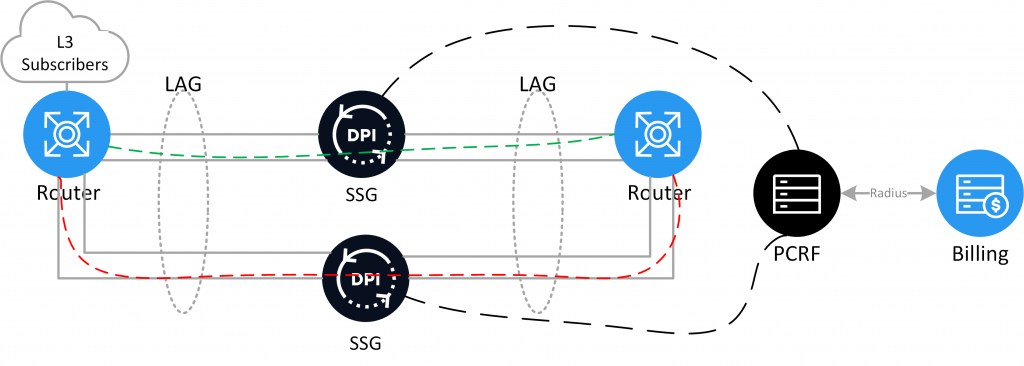

Reserva en caliente L3 BRAS/BNG a través de LAG (Active-Active)

Se colocan dos dispositivos en un mismo LAG con el equilibrio de tráfico IP src / IP dst configurado. Esto permite compartir la carga entre los dos dispositivos, de modo que si uno falla, todo el tráfico se redireccionará a un servidor. Para su implementación necesitará una licencia activa para cada servidor BRAS.

Reserva fría L3 BRAS/BNG en LAG (Active-Standby)

Se colocan dos dispositivos en un mismo LAG, donde parte de los enlaces está inactiva. En caso de fallo de los enlaces primarios, se activan los enlaces de reserva. Esto permite redireccionar todo el tráfico a un servidor si el servidor primario falla. Para su implementación necesitará una licencia de reserva para el servidor de reserva BRAS.

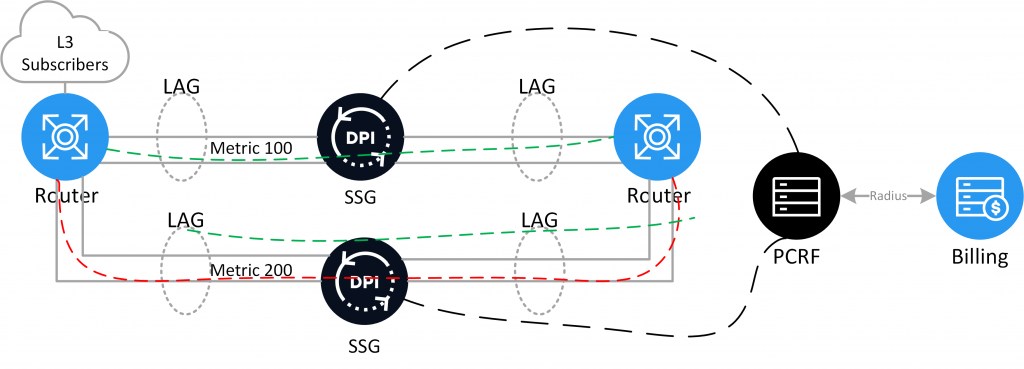

Reserva fría L3 BRAS/BNG mediante enrutamiento (Active-Standby)

Se colocan dos dispositivos en diferentes LAG. La ruta principal del tráfico pasa a través del servidor activo. El enrutamiento se configura en los enrutadores de borde. Si el servidor primario falla, se cambia a la ruta de reserva. En situaciones en las que el servidor primario falla, esto permite redireccionar todo el tráfico a un servidor de reserva a través de una ruta alternativa. Para su implementación necesitará una licencia de reserva para el servidor de reserva BRAS.

L2-Connected BRAS

L2-Connected BRAS/BNG y el suscriptor tienen una conexión L2 directa, por lo que éste ve las direcciones MAC originales, la etiqueta VLAN o Q-in-Q, las solicitudes DHCP a partir de las cuales se generan las solicitudes Radius. La asignación de direcciones IP se realiza en el atributo Radius-Accept.

Variantes de BRAS/BNG L2:

- DHCP — al suscriptor se le asigna una dirección IP a través de Stingray DHCP Proxy y pasa por la AAA en la Facturación. A continuación, el Stingray lo termina y se dirige al border.

- Static IP — el suscriptor tiene una dirección IP fija, pasa la AAA en Facturación AAA a través de la autorización ARP, se termina con el Stingray y llega al border.

- PPPoE — el suscriptor aumenta el túnel PPP con Stingray, a través de la autorización de inicio de sesión/contraseña pasa la AAA en Facturación, se termina con el Stingray y llega al border.

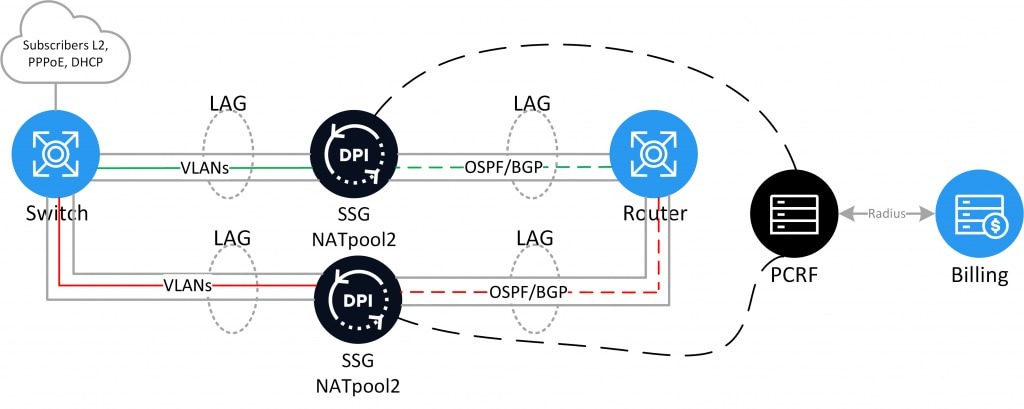

Reserva fría L2 BRAS/BNG (DHCP, PPPoE) (Active-Standby)

Se colocan dos dispositivos en el mismo dominio L2. El servidor activo responde a las solicitudes de los usuarios y realiza la autorización. Si la autorización es exitosa, las rutas se anuncian a través de OSPF/BGP al enrutador de borde. Enrutamiento dinámico. Si el servidor primario falla, el servidor de reserva empieza a responder a las solicitudes y a anunciar los suscriptores. El proceso de conmutación puede realizarse de diferentes maneras, por ejemplo, aumentando los puertos del servidor de reserva o reescribiendo la VLAN en el conmutador de agregación. Para su implementación necesitará una licencia de reserva para el servidor de reserva BRAS.

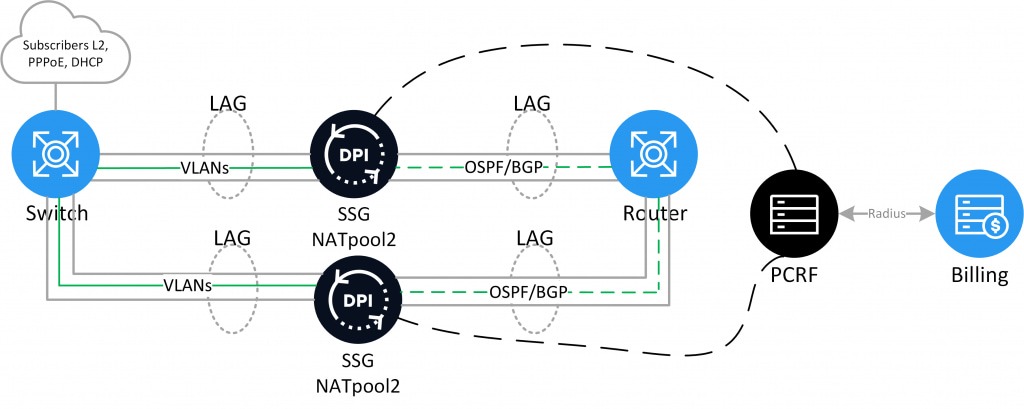

Reserva en caliente L2 BRAS/BNG (DHCP, PPPoE) (Active-Active)

Se colocan dos dispositivos en el mismo dominio L2. Ambos servidores están activos y responden a las peticiones del usuario y se autentifican. Para la tecnología PPPoE, este modo es soportado en base al diseño de la propia tecnología, donde el suscriptor establece una conexión con el servidor que respondió primero. Para DHCP este modo está en desarrollo. Si la autorización es exitosa, las rutas se anuncian a través de OSPF/BGP al enrutador de borde. Enrutamiento dinámico. Si uno de los servidores falla, el segundo servidor empieza a procesar todo el tráfico. Para su implementación necesitará una licencia activa para cada servidor BRAS.